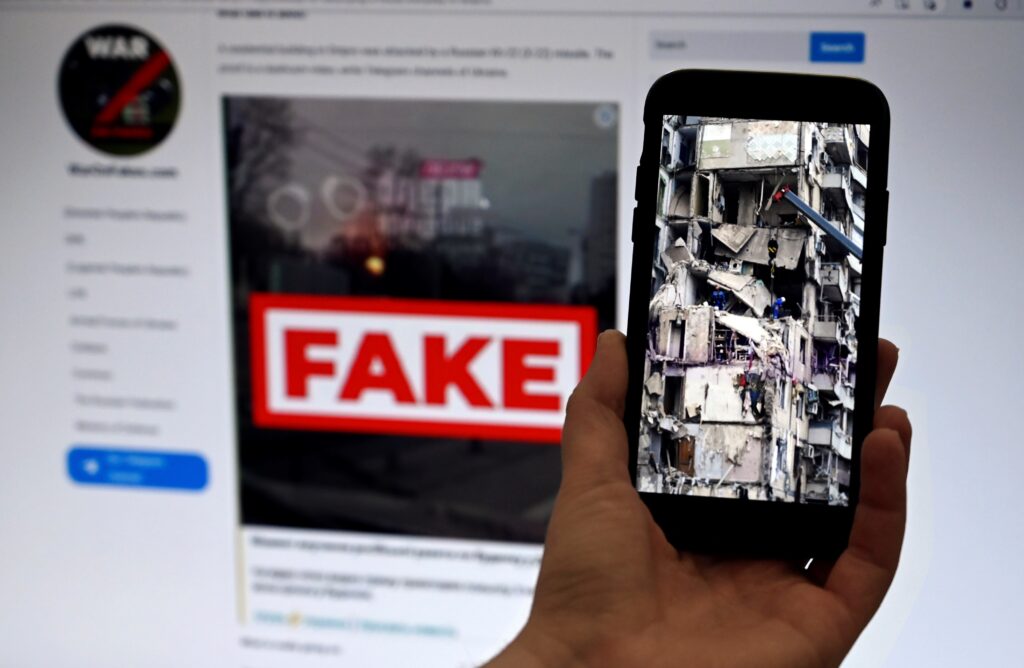

Les combats continuent en Ukraine pour le contrôle de Pokrovsk et sur le front de l’Est, mais sur les réseaux sociaux la messe est dite: appuyant le discours prorusse, des vidéos virales générées par l’IA montrent une armée ukrainienne en déroute, à grand renfort de faux soldats en larmes.Le président ukrainien Volodymyr Zelensky a reconnu une situation “compliquée” à Pokrovsk où les troupes ukrainiennes, moins nombreuses et moins bien équipées, luttent pour empêcher que l’étau russe ne se referme sur ce nœud logistique dont Moscou tente de s’emparer depuis un an.Des dizaines de vidéos générées par l’IA de soldats ukrainiens rendant les armes, ou en pleurs en chemin pour le front, se sont répandues sur les réseaux sociaux en novembre, accumulant des millions de vues et donnant corps et visages au récit prorusse d’une armée ukrainienne en déroute.Elles s’inscrivent “dans le narratif plus large que l’on voit depuis le début de l’invasion, selon lequel (le président) Zelensky force des jeunes et des vieillards à aller au front parce que l’armée ne s’en sort pas”, explique Pablo Maristany de las Casas, analyste de la propagande pro-Kremlin à l’Institut pour le dialogue stratégique (ISD).”Il y a toujours un événement sur lequel vont se construire les fausses informations”, renchérit Carole Grimaud, chercheuse en sciences de l’information à l’université d’Aix-Marseille (France) et spécialiste de la Russie. Ici, il s’agit d'”instrumentaliser l’incertitude” autour de la situation sur le terrain, pour manipuler l’opinion.Sur une vidéo, un homme qui affirme “quitter Pokrovsk” marche sans difficulté malgré une jambe dans le plâtre, un brancard semble léviter et des jambes sans corps apparaissent au milieu de militaires identifiés par des drapeaux ukrainiens plus ou moins réussis.Autant d’incohérences visuelles qui restent typiques des contenus créés par l’IA générative, mais qui deviennent de plus en plus difficiles à repérer à l’oeil nu.Une autre série de fausses vidéos, certaines avec le logo de l’outil de création de vidéos Sora d’OpenAI, montrent des soldats en uniformes ukrainiens pleurant et suppliant de ne pas être envoyés au front.Mais ce sont les visages de streamers russes qui semblent avoir été utilisés pour générer ces images. “Bien sûr que ce n’est pas moi”, a commenté Alexeï Goubanov, un exilé dont le visage apparaît dans certaines vidéos et qui a déclaré sur YouTube que ces faux contenus “font le jeu de la propagande russe”.- “humaniser” la désinformation -L’Observatoire européen des médias numériques (EDMO) a comptabilisé plus de 2.000 articles de vérification publiés dans l’UE depuis le début de l’invasion russe, l’IA devenant de plus en plus présente dans les contenus manipulateurs.Pour Ian Garner, spécialiste de la propagande russe au Centre d’études totalitaires de l’Institut Pilecki à Varsovie, la production de fausses informations “est une vieille technique, c’est la technologie qui est nouvelle”, l’IA rendant la désinformation plus efficace en permettant de “l’humaniser”.Ce genre de vidéos “effritent le moral en Ukraine en disant +regardez, cet homme pourrait être votre frère+”, mais aussi l’opinion publique dans les pays alliés en martelant l’idée “que la victoire de la Russie est inévitable”. Et en Russie, elles rassurent la population, explique-t-il.TikTok a indiqué à l’AFP que les comptes qui semblent à l’origine de la publication de ces vidéos avaient été supprimés, mais pas avant que l’un d’eux recueille plus de 300.000 “j’aime” et plusieurs millions de vues.Contacté par l’AFP, OpenAI a indiqué avoir mené une enquête, sans plus de précision.Cela n’empêche pas les vidéos de continuer à circuler: l’AFP les a retrouvées, entre autres, sur Instagram, Telegram, Facebook et X dans des publications en grec, roumain, bulgare, tchèque, polonais et français, sur le site d’un hebdomadaire russe et dans un tabloïd serbe.L’impact d’une fausse vidéo est difficile à mesurer, mais selon Carole Grimaud, “lorsqu’il y a répétition, la représentation que les gens ont peut changer”.Les chatbots dont les réponses sont générées par l’IA sont eux aussi instrumentalisés par le discours pro-Kremlin.Une étude de l’ISD publiée en octobre a montré que parmi les réponses de certains des programmes les plus populaires, “presque un cinquième ont cité des sources liées à l’État russe, dont beaucoup sanctionnées dans l’UE”.Pour Pablo Maristany de las Casas, si certaines entreprises ont montré une volonté de lutter contre le détournement de leurs outils, “l’échelle et l’impact de la guerre informationnelle vont beaucoup plus vite que leur réponse”.